AI技術者 「ChatGPTのような生成AI=LLMの根本的な仕組みはわかりますか?」

小生 「え~と、人間の糠味噌ではなく脳味噌のナスではなくシナプスの・・・ え~と

わからん!」

天の声 「普段、生成AIがどうした、こうしたと能書きを言っているのに

そんなこともわからんのか!」

と聞こえてきそうです。

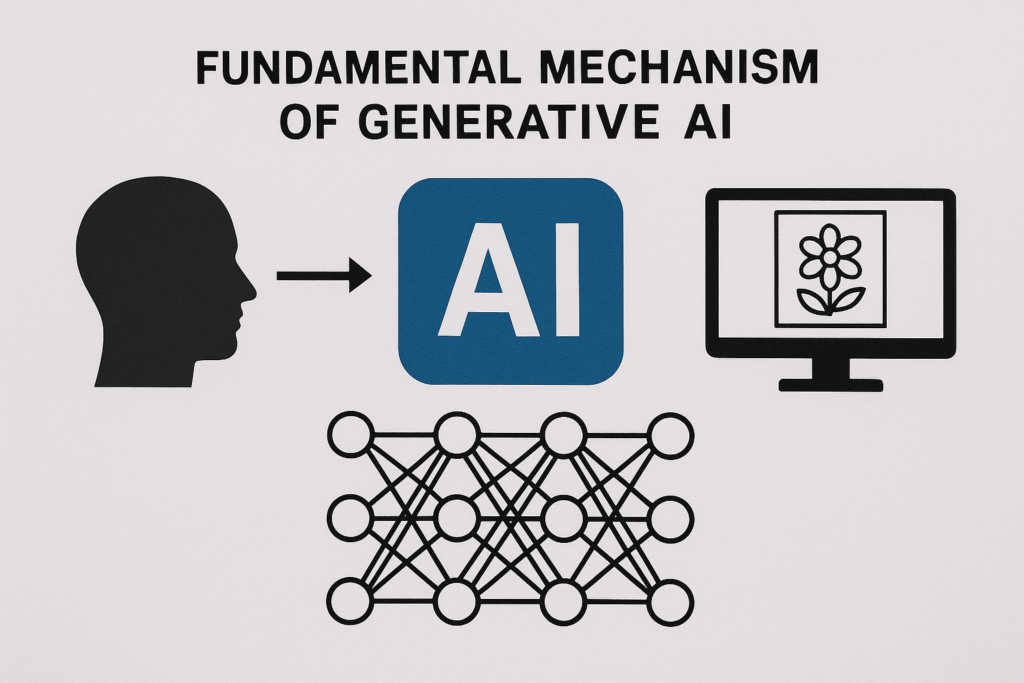

今般、X(ツイッター)で以下の紹介がありました。

『素人でもChatGPTが何故人間みたいに回答するのかが、根本から分かる超優良級動画。

大規模言語モデル(LLM)の仕組みを7分で学べる。

AI活用も根本の仕組みを知った上で使うと応用が効く。

パラーメーター、事前訓練、RLHF、Attentionなど意味がわかると楽しい。』

それでは、皆様ご覧ください。

わかりましたか?

小生 ??? だめだこりゃ。

ご安心くださいまし。

小生の得意中の得意である会話方式で理解することにしました。

中学生: 博士!この前教えてもらったLLMの話、すごく面白かったです!でも、もっと簡単に、学校の友達にもわかるくらいに教えてもらえませんか?なんか、AI博士と中学生の会話みたいに!

AI博士: おお、それはいい考えだね!もちろんだとも。よし、じゃあ私がAI博士、君は中学生の役で始めよう!

AI博士: さて、〇〇君(中学生の名前を想定)、前に話した大規模言語モデル(LLM)っていうのはね、一番簡単に言うと「次にどんな言葉が来るか」を予測するのが得意なすごい仕組みなんだ。

中学生: 次にどんな言葉が来るか? え、それだけですか?

AI博士: そう。例えば、「今日は天気がいいから、〇〇に行こう!」って文章があったら、〇〇には「公園」とか「ピクニック」とか、いろいろな言葉が考えられるよね。LLMは、「今日は天気がいいから、」の後に、「公園」が来る確率は何パーセント、「ピクニック」が来る確率は何パーセント…みたいに、次に続く可能性のある言葉全部に「これくらいの可能性だよ」っていう数字(確率)を割り当てるんだ。

中学生: へえ!一つに決めちゃうんじゃなくて、全部の可能性を考えるんですね!

AI博士: その通り!チャットボットが何か答えるときも、この「次にどんな言葉が来そうか」っていう予測をどんどん繰り返して、文章を作っていくんだ。例えるなら、AIのセリフだけが抜けてる映画の脚本があって、君が最初のセリフを入れると、機械が次の言葉を予測してくれて、それを繰り返すとAIのセリフが完成する、っていうイメージだね。

中学生: なるほど!だんだんセリフが埋まっていくんですね!

AI博士: そうそう。でね、チャットボットの答えが毎回ちょっと違うことってあるでしょ? それは、必ずしも一番確率が高い言葉を選ぶだけじゃなくて、たまに確率がちょっと低い言葉もランダムに選んだりするからなんだ。そうすると、もっと自然な文章になる傾向があるんだよ。

中学生: あ、だから全く同じ答えにならないんですね!どうしてそんなに予測ができるようになったんですか?

AI博士: それはね、「訓練(トレーニング)」をしたからなんだ。インターネットにあるものすごくたくさんの文章を、まるで勉強みたいに読み込んだんだよ。どれくらいかって言うと、GPT-3っていう有名なLLMだと、人間が休みなく24時間読み続けても、2600年以上かかるくらいの量の文章を読んだらしい。それより新しいモデルは、もっともっとたくさん勉強してる。

中学生: 2600年!?すごい量だ…!それで賢くなるんですね。

AI博士: そう。この勉強の仕方は、たくさんの「ダイヤル」を調整していくのに似ているんだ。このダイヤルの設定によって、モデルが次にどの言葉を選ぶかの確率が変わるんだよ。「大規模」って言われるのは、このダイヤルの数が数千億個も、いやもっとたくさんあるからなんだ。

中学生: ええ!?そんなにたくさんのダイヤルがあるんですか!人間が一個ずつ回すわけじゃないですよね?

AI博士: いい質問だね!人間が手で設定するわけじゃない。最初はでたらめに設定されてるから、意味不明なことしか言えないんだ。でも、訓練では、お手本の文章をたくさん使って、このダイヤルを少しずつ調整して洗練させていくんだ。

中学生: どうやって調整するんですか?

AI博士: 例えば、「今日は天気がいいから、公園に行こう!」っていうお手本の文章があったとするね。その文章の最後の「行こう!」だけを隠して、モデルに「今日は天気がいいから、公園に」までを入力するんだ。モデルが予測した言葉と、実際のお手本の言葉(「行こう!」)を比べるんだ。もしモデルが違う言葉を予測したら、お手本の「行こう!」っていう正しい言葉を選ぶ確率がちょっと高くなって、間違った言葉を選ぶ確率がちょっと低くなるように、全部のダイヤルを少しずつ回すんだ。これを何兆回も繰り返すことで、訓練した文章に対しては正確な予測ができるようになるし、初めて見る文章に対しても、より「それらしい」予測ができるようになるんだ。

中学生: なるほど、クイズに答えさせて、正解に近づくようにダイヤルを調整していく感じですね!

AI博士: そうそう、まさにそんな感じ!ただね、これで「インターネットにある文章を自動で完成させる」っていうのはできるようになったんだけど、それだけじゃ「役に立つAIアシスタント」にはなれないんだ。

中学生: え、どうしてですか?文章は作れるようになったのに?

AI博士: たとえば、間違った情報を言ったり、ひどい言葉を使ったりするかもしれないでしょ? それじゃ困るよね。だから、もう一つ大事な訓練をするんだ。それが「人間のフィードバックによる強化学習(RLHF)」っていうものだ。

中学生: 人間のフィードバック?

AI博士: そう。人間がモデルの作った文章を見て、「これは変だよ」「これは役に立たない」「これはダメだよ」っていう「ダメ出し」をするんだ。そのダメ出しをもとに、またモデルのダイヤルを調整して、「人間が良いと思うような答え方」を学習させるんだ。

中学生: なるほど!ただ賢いだけじゃなくて、人間の先生に「こういう風に答えなきゃダメだよ」って教えてもらうんですね!

AI博士: その通り!それで、もっとたくさんの計算の話なんだけど、この訓練、特にたくさんの文章を読み込む最初の訓練(事前訓練って言うんだ)には、ものすごーくたくさんの計算が必要なんだ。1秒間に10億回計算できても、一番大きいモデルだと1億年以上かかるくらいの計算らしい。

中学生: 1億年!?気が遠くなる…!どうやってそんな計算ができるんですか?

AI博士: それを可能にしているのが、GPUっていう特別なコンピューターチップなんだ。これは、たくさんの計算を同時に、一気にやるのが得意なんだよ。

中学生: へえ、GPUってすごいんですね!

AI博士: そう。あと、この数年でLLMがすごく賢くなった理由の一つに、「トランスフォーマー」っていう新しい仕組みのモデルが登場したことがあるんだ。

中学生: トランスフォーマー?ロボットみたい!

AI博士: 名前は似てるけど違うんだ(笑)。前のモデルは、文章を単語一つずつ順番に読んで処理していたんだけど、トランスフォーマーは文章全体を、最初から最後までまとめて一度に処理できるんだ。

中学生: 一度にまとめて?それは速そう!

AI博士: そうだね。トランスフォーマーの中ではね、まず言葉をコンピューターが扱える「長い数値のリスト」に変えるんだ。これは、言葉の意味を数値で表しているイメージだね。

中学生: 言葉が数字になるんですね。

AI博士: そう。そして、トランスフォーマーの一番すごい特徴が「アテンション」っていう計算なんだ。これは、周りの単語の数値リストと情報をやり取りして、その単語の数値リストの意味を更新するんだ。

中学生: 情報のやり取り?

AI博士: そ う。例えば、「銀行」を意味する「バンク(bank)」と、「川岸」を意味する「バンク(bank)」って、同じ単語だけど意味が違うでしょ? 「川の近くのバンク」って文章なら、アテンションの計算で、「バンク」っていう単語の数値リストが「川岸」っていう意味を表すように変化する、みたいな感じかな。これもたくさんの単語で同時に行われるんだ。

中学生: あー!なるほど!文脈で言葉の意味が変わるのを、数字のリストで表現するんですね!賢い!

AI博士: そういうこと!こういう複雑な計算を繰り返すことで、モデルは次にどんな言葉が来るかを予測するために必要な、言葉の意味や文脈に関する色々な情報を数値として持てるようになるんだ。

中学生: なんか、すごくたくさんの部品があって、複雑に動いている感じですね。

AI博士: まさにそうだね。研究者は、このモデルがどうやって勉強して、どう計算するか、っていう基本的な「設計図」は作るんだけど、モデルが具体的にどんな答えを出すか、どういう振る舞いをするかは、訓練で数千億個のダイヤルがどう調整されたかで決まるんだ。だから、「なんでこの答えになったの?」って、一つ一つ理由を説明するのは、実はすごく難しいんだよ。

中学生: 設計図はわかるけど、できあがったものの細かい動きは、訓練次第ってことなんですね。

AI博士: その通り。でも、結果として、このLLMの予測を使って文章を作ると、びっくりするくらい滑らかで、面白くて、役に立つ文章が出てくるんだ。

中学生: すごい!なんか、AIと話しているのがもっと面白く感じてきました!博士、ありがとうございました!

AI博士: どういたしまして!もっと知りたくなったら、アテンションとかトランスフォーマーをもっと詳しく説明している動画もあるから、見てみるのもいいかもね。

皆さん、わかりましたか?

小生?少しわかりました。残尿感あり。

今回はこのくらいにしておきましょう。

股の機会に。

お後がよろしいようで。

◆お願い (お手数お掛けします) ブログを読まれた方は下記2つのボタンを順番にクリックをお願いします。 クリックしてアクセスするだけで点数が入り(投票され)順位が上がります。 アクセス後は何もせず、本ブログに戻ってきてください。